在人工智能浪潮席卷全球的背景下,YC中国创始人陆奇提出一个重要观点:人工智能时代,芯片和底层软件基本都要重做。这一论断深刻揭示了当前技术发展中的核心挑战与机遇,尤其在人工智能基础软件开发领域,引发了行业对技术栈重构的深度思考。

随着人工智能从算法驱动转向系统驱动,传统计算架构已难以满足海量数据处理和复杂模型训练的需求。陆奇指出,人工智能不仅是应用层的创新,更是对底层硬件和软件体系的全面革新。在芯片层面,传统的通用CPU架构在并行计算能力和能效比上存在瓶颈,而AI专用芯片(如GPU、TPU、NPU等)通过针对神经网络计算的优化设计,实现了数量级的性能提升。这种从“通用计算”到“领域专用计算”的转变,要求芯片设计从指令集、内存架构到计算单元进行全面重构,以支撑大规模模型训练和实时推理。

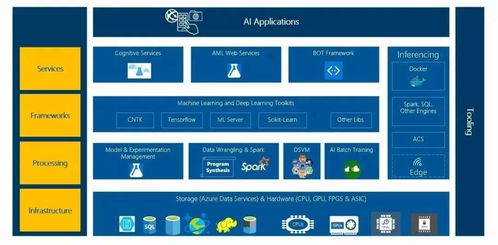

在基础软件层面,人工智能同样驱动着操作系统、编译器、开发框架等核心组件的重塑。传统软件栈是为确定性的、规则驱动的任务设计的,而人工智能应用具有高度的不确定性、数据密集性和迭代性。因此,新一代基础软件需要解决几个关键问题:

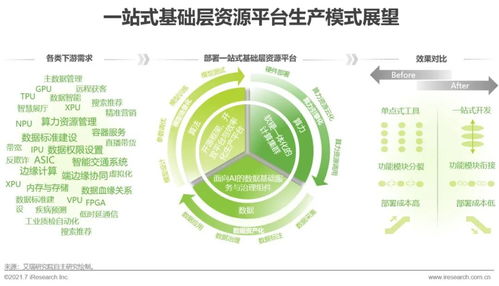

一是异构计算资源的统一调度与管理。AI系统往往需要同时调用CPU、GPU、FPGA等多种计算单元,软件栈需要提供高效的资源抽象和调度能力,实现算力的弹性分配。

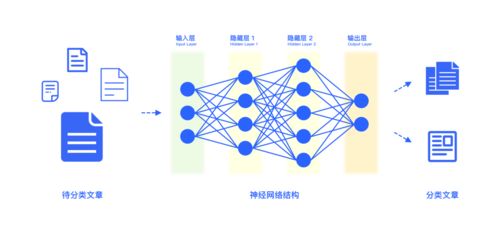

二是数据与计算的高效协同。人工智能模型训练涉及海量数据的加载、预处理和流水线处理,软件需要优化数据流与计算流的重叠执行,减少I/O瓶颈。

三是开发效率与部署便捷性的平衡。从TensorFlow、PyTorch等深度学习框架的演进可以看出,基础软件正朝着更易用、更灵活的方向发展,同时通过编译器优化(如XLA、TVM)实现跨硬件平台的性能可移植性。

陆奇强调,人工智能基础软件的重构不仅是技术挑战,更是生态竞争。开源框架和工具链的成熟降低了开发门槛,但如何构建从芯片指令集到上层应用的垂直优化体系,成为企业构建护城河的关键。例如,英伟达通过CUDA生态将硬件优势转化为软件开发生态,而新兴的AI芯片公司也在积极构建自己的软件栈以形成差异化竞争力。

人工智能基础软件的发展将呈现三大趋势:一是软件定义芯片(Software-Defined Silicon)成为主流,硬件设计将更加贴近算法需求;二是系统级协同设计,通过算法、软件、硬件的联合优化实现整体效率突破;三是开源与开放标准加速行业融合,ONNX、MLIR等中间表示和编译器框架正在推动工具链的统一。

总而言之,陆奇的观点揭示了人工智能时代技术基础重构的必然性。芯片和基础软件的重做不仅是性能优化的需求,更是适应智能计算新范式的根本转变。对于开发者、企业和投资者而言,理解并投身于这一波底层技术变革,将是把握人工智能时代机遇的关键所在。